La parola entropia ha significato diverso nella termodinamica e nella teoria dell'informazione? Inoltre noto che spesso chi contesta la teoria dell'evoluzione dichiara che questa teoria viola il 2° principio della termodinamica. Non capisco il nesso fra entropia informazioni e altro.

La parola entropia ha significato diverso nella termodinamica e nella teoria dell'informazione? Inoltre noto che spesso chi contesta la teoria dell'evoluzione dichiara che questa teoria viola il 2° principio della termodinamica. Non capisco il nesso fra entropia informazioni e altro.

![]()

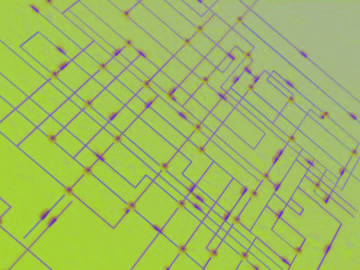

Il concetto di entropia ![]()

![]() [100] è stato introdotto agli inizi del XIX secolo nel campo della termodinamica classica, in stretta connessione con il secondo principio. Nel contesto termodinamico l’entropia rappresenta una grandezza caratteristica dello stato di un sistema fisico in grado di esprimere la capacità del sistema stesso di essere sede di trasformazioni spontanee e, di conseguenza, la perdita di capacità a compiere lavoro quando tali trasformazioni avvengono. In termini semplificati, il valore dell’entropia cresce quando il sistema subisce variazioni spontanee e quindi perde parte della sua capacità a subire tali variazioni e compiere lavoro. L'approccio molecolare introdotto dalla meccanica statistica ha successivamente generalizzato l'entropia agli stati di non-equilibrio correlandola più strettamente al concetto di ordine, precisamente alle possibili diverse disposizioni dei livelli molecolari e quindi differenti probabilità degli stati in cui può trovarsi macroscopicamente un sistema

[100] è stato introdotto agli inizi del XIX secolo nel campo della termodinamica classica, in stretta connessione con il secondo principio. Nel contesto termodinamico l’entropia rappresenta una grandezza caratteristica dello stato di un sistema fisico in grado di esprimere la capacità del sistema stesso di essere sede di trasformazioni spontanee e, di conseguenza, la perdita di capacità a compiere lavoro quando tali trasformazioni avvengono. In termini semplificati, il valore dell’entropia cresce quando il sistema subisce variazioni spontanee e quindi perde parte della sua capacità a subire tali variazioni e compiere lavoro. L'approccio molecolare introdotto dalla meccanica statistica ha successivamente generalizzato l'entropia agli stati di non-equilibrio correlandola più strettamente al concetto di ordine, precisamente alle possibili diverse disposizioni dei livelli molecolari e quindi differenti probabilità degli stati in cui può trovarsi macroscopicamente un sistema ![]() [359]. L’entropia è dunque espressione del “grado di disordine” di un sistema: un aumento del disordine corrisponde ad aumento di entropia e, viceversa, una diminuzione del disordine è associata a una diminuzione di entropia. Come misura del grado di disordine o di indeterminazione di un sistema, il concetto di entropia ha potuto essere esteso ad ambiti di applicazione lontani dalla fisica, primo fra tutti la teoria dell’informazione. Negli anni quaranta Shannon riuscì a definire l’equazione con cui calcolare il livello di imprevedibilità di una fonte d’informazione, constatando che la sua formula era praticamente uguale a quella con cui Boltzmann aveva calcolato l’entropia di un sistema termodinamico. Per Shannon il problema era misurare quanta “informazione” contiene un dato messaggio, e quindi, di conseguenza, quanto costa inviarlo, dato un sistema di trasmissione e le difficoltà che un canale di trasmissione (in generale disturbato da “rumore” ) può trovare. La sua intuizione fu quella di equiparare il grado di ignoranza al disordine: il “messaggio” è quella quantità di informazione che fa passare il ricevente da uno stato di incertezza ad uno stato di ordine (o, se si vuole, di minor incertezza). La quantità di informazione, essendo il negativo della quantità di incertezza intrinseca, diventa qualcosa di molto prossimo al “disordine” della meccanica statistica. L’entropia così introdotta nella teoria dell’informazione è quindi misura del grado di complessità di un messaggio emesso da una sorgente: come dimostrato nel primo teorema di Shannon, essa fornisce il numero medio minimo di simboli necessari alla codifica del messaggio stesso. In questo contesto l'entropia misura dunque la quantità d’incertezza o informazione presente in un segnale aleatorio, che può essere interpretata anche come la minima complessità descrittiva di una variabile aleatoria, ovvero il limite inferiore della compressione dei dati. La connessione con l'entropia dei sistemi fisici può quindi recuperarsi nel rapporto di compressione: al diminuire della temperatura (in termodinamica) corrisponde la riduzione della ridondanza del segnale e quindi l'aumento della compressione (in teoria dell’informazione). L'entropia dell'informazione raggiunge un minimo che in generale è diverso da zero, al contrario di quanto avviene per l'entropia termodinamica.

[359]. L’entropia è dunque espressione del “grado di disordine” di un sistema: un aumento del disordine corrisponde ad aumento di entropia e, viceversa, una diminuzione del disordine è associata a una diminuzione di entropia. Come misura del grado di disordine o di indeterminazione di un sistema, il concetto di entropia ha potuto essere esteso ad ambiti di applicazione lontani dalla fisica, primo fra tutti la teoria dell’informazione. Negli anni quaranta Shannon riuscì a definire l’equazione con cui calcolare il livello di imprevedibilità di una fonte d’informazione, constatando che la sua formula era praticamente uguale a quella con cui Boltzmann aveva calcolato l’entropia di un sistema termodinamico. Per Shannon il problema era misurare quanta “informazione” contiene un dato messaggio, e quindi, di conseguenza, quanto costa inviarlo, dato un sistema di trasmissione e le difficoltà che un canale di trasmissione (in generale disturbato da “rumore” ) può trovare. La sua intuizione fu quella di equiparare il grado di ignoranza al disordine: il “messaggio” è quella quantità di informazione che fa passare il ricevente da uno stato di incertezza ad uno stato di ordine (o, se si vuole, di minor incertezza). La quantità di informazione, essendo il negativo della quantità di incertezza intrinseca, diventa qualcosa di molto prossimo al “disordine” della meccanica statistica. L’entropia così introdotta nella teoria dell’informazione è quindi misura del grado di complessità di un messaggio emesso da una sorgente: come dimostrato nel primo teorema di Shannon, essa fornisce il numero medio minimo di simboli necessari alla codifica del messaggio stesso. In questo contesto l'entropia misura dunque la quantità d’incertezza o informazione presente in un segnale aleatorio, che può essere interpretata anche come la minima complessità descrittiva di una variabile aleatoria, ovvero il limite inferiore della compressione dei dati. La connessione con l'entropia dei sistemi fisici può quindi recuperarsi nel rapporto di compressione: al diminuire della temperatura (in termodinamica) corrisponde la riduzione della ridondanza del segnale e quindi l'aumento della compressione (in teoria dell’informazione). L'entropia dell'informazione raggiunge un minimo che in generale è diverso da zero, al contrario di quanto avviene per l'entropia termodinamica.

Domenico Elia, fisico

ultimo aggiornamento aprile 2015