La quantità di dati è in crescita. richiamando i 300 Petabyte, mediamente quanto tempo gli algoritmi di verifica dei dati (per teorie, classificazioni, ...) hanno bisogno? Vorrei chiedere ancora un altro piccolo dettaglio, si conoscono molti algoritmi in matematica discreta che sono inclusi in NP, ne esistono anche qua, con magari qualche approssimazione per renderlo polinomiale? Cristian

La quantità di dati è in crescita. richiamando i 300 Petabyte, mediamente quanto tempo gli algoritmi di verifica dei dati (per teorie, classificazioni, ...) hanno bisogno? Vorrei chiedere ancora un altro piccolo dettaglio, si conoscono molti algoritmi in matematica discreta che sono inclusi in NP, ne esistono anche qua, con magari qualche approssimazione per renderlo polinomiale? Cristian

![]()

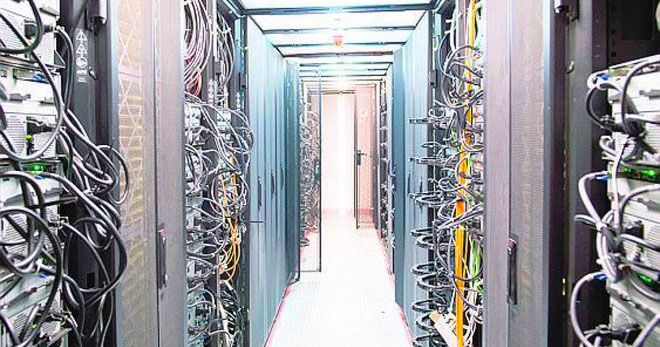

L’idea vincente è l’uso di più computer in parallelo. Alcuni fra i più importanti centri di ricerca hanno oramai unito le proprie risorse di calcolo per realizzare, grazie alla tecnologia GRID computing, un mega calcolatore distribuito della potenza di svariati teraflops, ovvero in grado di svolgere 1012 calcoli tra variabili (operazioni in virgola mobile) al secondo. La collaborazione scientifica a livello informatico diventa così un’organizzazione virtuale; ciascun membro è dotato di un certificato personale, cioè un documento informatico che ne garantisce l’identità. I membri accedono ai dati e svolgono le analisi con le risorse di calcolo distribuito attraverso la GRID. La potenza di calcolo è disponibile in svariati centri sparsi nel mondo: l’utente sceglie lui stesso, ma più spesso avvalendosi di servizi automatici, i siti maggiormente disponibili e affidabili ove inviare i programmi di lavoro, detti job, della sua analisi. Passano diversi mesi (o anche alcuni anni) dal momento in cui il rilevatore dell’esperimento ha raccolto i segnali degli eventi oggetto dello studio di fisica da pubblicare. Decine, centinaia o migliaia di persone hanno contribuito al risultato finale, secondo le proprie competenze scientifiche o tecnologiche. Gli scienziati scrivono programmi per l’analisi dei dati dove si usano approssimazioni polinomiali, convoluzioni di curve, fit di andamenti; la matematica e la statistica sono punti cardine delle analisi dati.

PER SAPERNE DI PIU’

Percorso divulgativo Un viaggio dalla collisione alla pubblicazione scientifica

Andrea Gozzelino, fisico

ultimo aggiornamento giugno 2019